边缘智能创新应用大赛获奖作品系列三:边缘智能强力驱动,机器人天团花式整活赋能千行百业

本文博客为智能机器人赛道中独立开发者、高校开发者和企业开发者的优秀项目分享。

Qualcomm 边缘计算 QCS6490时间:2024-12-16 14:15:11

边缘智能创新应用大赛获奖作品系列二:工业质检“火眼金睛”上线,缺陷漏洞一网打尽

本文博客为工业智能质检赛道中高校开发者和企业开发者的优秀项目分享。

Qualcomm 边缘计算 QCS6490时间:2024-12-16 14:08:23

边缘智能创新应用大赛获奖作品系列一:智能边缘计算✖软硬件一体化,开启全场景效能革命新征程

本文博客为边缘智能计算赛道的获奖作品,分别来自独立开发者、高校开发者和企业开发者的优秀项目分享。

Qualcomm 边缘计算 QCS6490时间:2024-12-16 14:07:46

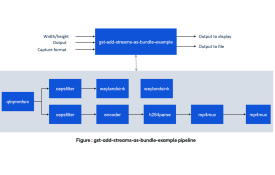

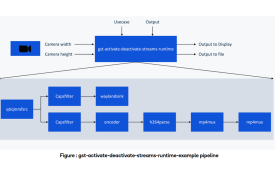

高通 Linux Gstreamer 用户手册(五)

本文主要介绍Qualcomm Neural Processing SDK 用例。

Qualcomm Linux时间:2024-12-16 10:55:53

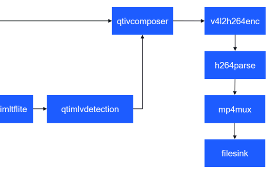

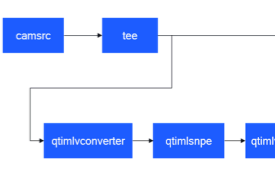

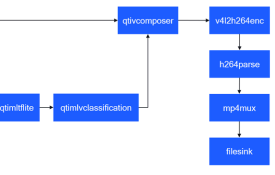

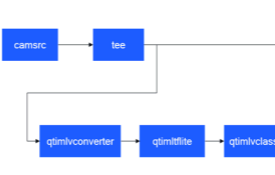

高通 Linux Gstreamer 用户手册(二)

本文主要介绍如何使用 TFLite 进行图像分类和编码,如何使用 TFLite 进行目标检测和显示。

Qualcomm Linux时间:2024-12-10 10:20:12

高通 Linux Gstreamer 用户手册(一)

GStreamer 提供 gst-launch-1.0 等命令行工具,帮助您运行 AI/ML 和多媒体用例。

Qualcomm Linux时间:2024-12-09 10:23:14

Qualcomm 开发者专区是 Qualcomm 联合CSDN 共同打造的面向中国开发者的技术专区。致力于通过提供全球最新资讯和最多元的技术资源及支持,为开发者们打造全面一流的开发环境。本专区将以嵌入式、物联网、游戏开发、Qualcomm® 骁龙™处理器的软件优化等技术为核心,打造全面的开发者技术服务社区,为下一代高性能体验和设计带来更多的想法和灵感。

加入 Qualcomm 开发者专区

申请成为“Qualcomm荣誉技术大使”

“Qualcomm荣誉技术大使”是Qualcomm开发者社区对开发者用户技术能力与影响力的认证体现,该荣誉代表Qualcomm社区对用户贡献的认可与肯定。

立即申请

高通技术公司推出头戴式AR开发套件骁龙Spaces™ XR开发者平台,助力打造无缝融合现实世界和数字世界边界的沉浸式体验。

为开发者提供实现创意的工具,并将变革头戴式AR的可能性,现已面市!